Razendsnelle technologische ontwikkeling heeft ertoe geleid dat het mogelijk is om steeds meer data in te zetten bij het nemen van beslissingen. Deze data moet echter wel van hoge kwaliteit zijn. Garbage in is garbage out. Pas als de datakwaliteit op orde is, krijg je waarvolle inzichten uit de analyses. Om datakwaliteit te garanderen moet er geïnvesteerd worden in standaardisatie en validatie, dit vereist bewustmaking van de grond af aan. Data kwaliteit is net zozeer een menselijke- als een technische uitdaging.

Lenard Koomen, Data Analytics Engineer, vertelt in dit interview over zijn visie op data kwaliteit. Hoe zorg je van de grond af aan voor een hoge data kwaliteit en hoe ga je ermee aan de slag?

In het kort

1. Lenards visie op data kwaliteit

Garbage in is garbage out

2. Data opschoning automatiseren?

Datawetenschappers besteden 60-80% van hun tijd aan het voorbereiden en verfijnen van data

3. Voorkomen is beter dan genezen

Hoe ga je aan de slag?

1. Lenards visie op data kwaliteit

Introductie

Mijn naam is Lenard, en tijdens mijn studie Aerospace Engineering aan de TU Delft raakte ik geïnteresseerd in machine learning, data science en AI. Deze interesse heeft uiteindelijk geleid tot een baan als data-analyst in de offshore windindustrie, waar ik onder andere verantwoordelijk was voor maandelijkse rapportages en het integreren van meerdere externe databronnen in het systeem. Nu werk ik bijna vier jaar bij Finaps, als Data Analytics Engineer, waar ik klanten help beter gebruik te maken van hun data.

“Je maakt het een metaalbewerker niet makkelijker door in plaats van een rechthoekig, homogeen blok staal, een bak vol kleine verschillende stukjes metaal te overhandigen.”

Wat is jouw visie op data kwaliteit?

Ik ben vooral gefascineerd geraakt door het idee dat er inzichten verborgen liggen in een groeiende berg data. In een proces dat te vergelijken valt met het delven en raffineren van bijvoorbeeld ijzererts, wordt de data gezuiverd en bewerkt, om uiteindelijk tot een waardevol eindproduct te leiden. De mate van zuiverheid van de grondstof en het aanleveren van de juiste tussenproducten zijn hierbij heel belangrijk; je maakt het een metaalbewerker niet makkelijker door in plaats van een rechthoekig, homogeen blok staal, een bak vol kleine verschillende stukjes metaal te overhandigen. Ik denk dat dit voor veel mensen vanzelfsprekend is, maar als het om data gaat lijkt men hier minder rekening mee te houden, met alle gevolgen van dien.

Uiteindelijk is datakwaliteit belangrijk, omdat men hier stroomafwaarts van afhankelijk is voor het nemen van de juiste zakelijke keuzes. Het waarborgen van datakwaliteit levert waarde door het verminderen van onzekerheid en het faciliteren van het zetten van de juiste koers voor een organisatie.

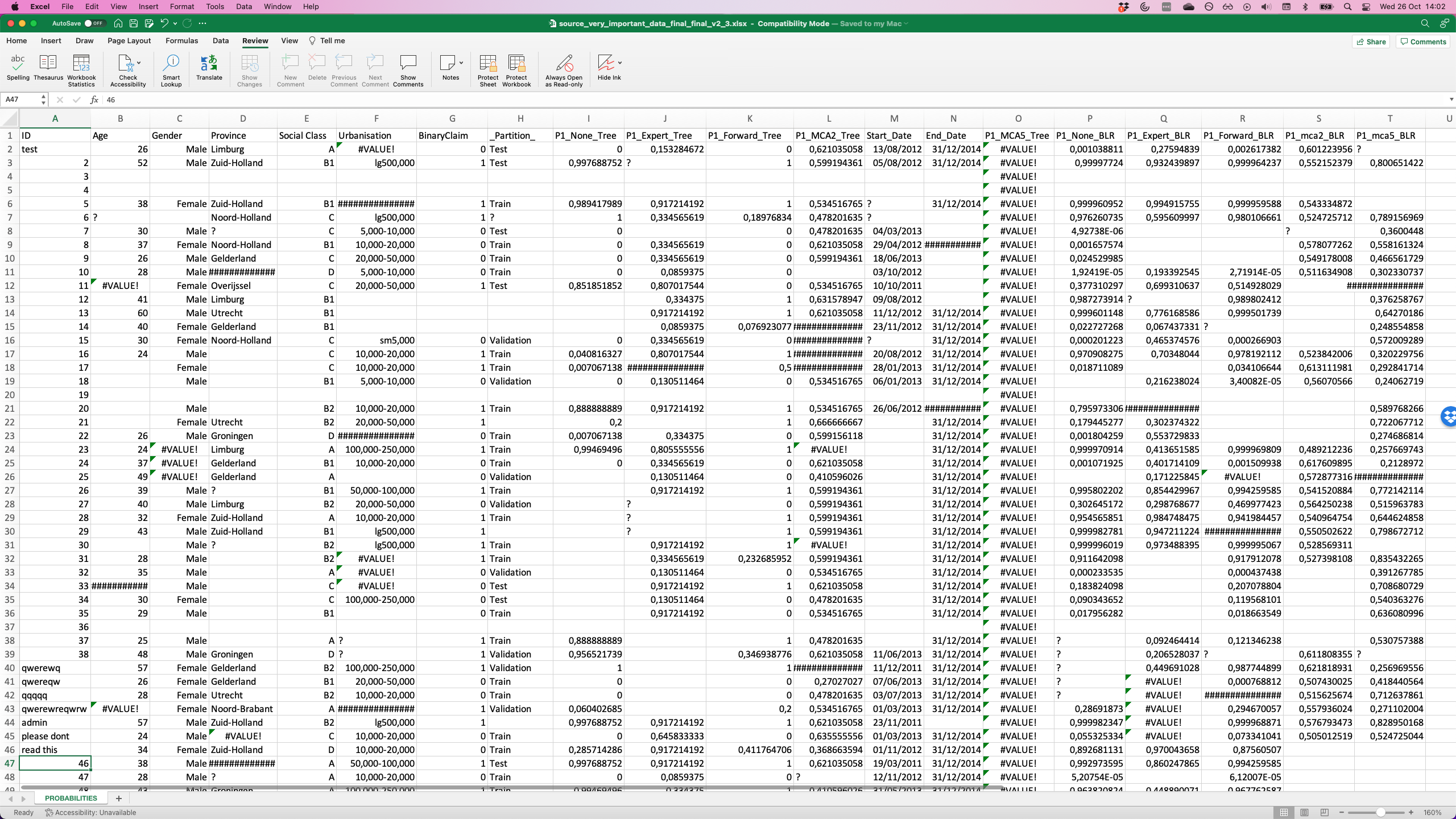

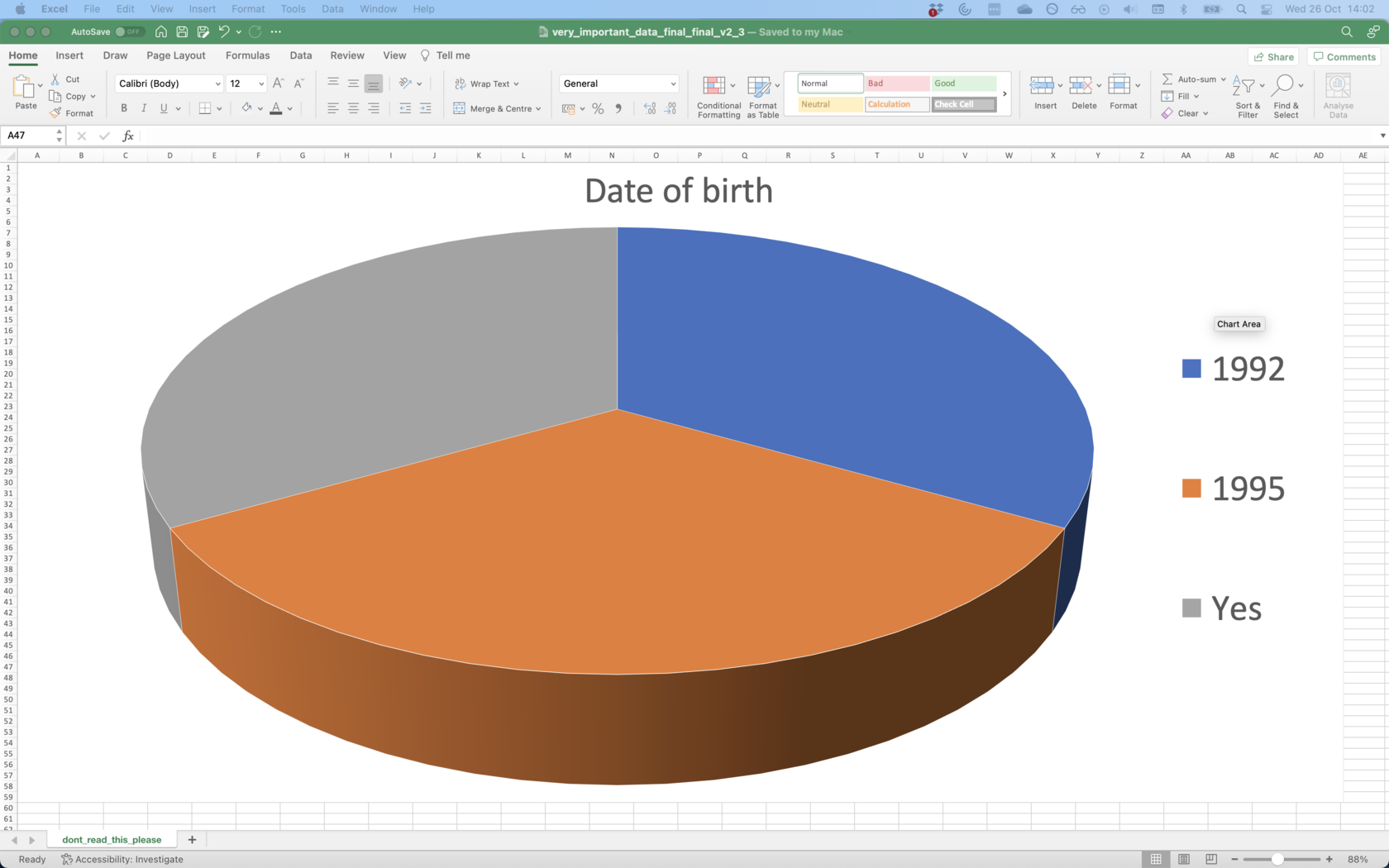

In mijn ervaring ontstaat slechte data kwaliteit vaak al aan het begin van het proces, wanneer ervan uit verschillende, vaak externe, bronnen data wordt bijeengebracht. De data zit dan initieel verpakt in gevarieerde set documenten met verscheidene templates. Kennis over de precieze definitie en nuances van elk veld overleeft deze stap meestal niet en is verborgen in de hersens van de mensen die bij het proces betrokken zijn. Doordat data vaak op complexe manieren wordt gecombineerd, kan slechte data kwaliteit zich snel door een proces verspreiden. Een bijkomstig probleem is dat, in tegenstelling tot expliciete programmeerfouten, foutieve data niet makkelijk kunnen worden opgemerkt.

2. Aan de slag

Hoe kun je data geautomatiseerd opschonen?

Er zijn verschillende manieren om data geautomatiseerd op te schonen en de kwaliteit te verbeteren. Een voorbeeld hiervan is het corrigeren van typefouten en spellingsvariaties in plaatsnamen. Dit kan worden gedaan door middel van een vergelijking met een dataset van “correcte” spellingswijzen, op basis van de bewerkingsafstand. Een tweede voorbeeld is dat ontbrekende data kunnen worden geïmputeerd, wat betekent dat deze achteraf wordt ingevuld op basis van een datamodel. Deze methodes maken zowel gebruik van specialistische kennis als de brondata zelf.

Echter, het achteraf oppoetsen van een dataset kan veel tijd, kennis, en geld kosten. Er wordt geschat dat data-scientists 60%-80% van hun tijd kwijt zijn aan het voorbereiden en raffineren van data, iets wat ik persoonlijk heb onderschat toen ik met dit werk begon. Hierdoor genereren organisatiebrede verbeteringen in datakwaliteit al snel waarde in de vorm van kostenbesparing, grondigere analyse, duidelijkere visualisatie, en gemotiveerdere data-analysten.

“Er wordt geschat dat data-scientists 60%-80% van hun tijd kwijt zijn aan het voorbereiden en raffineren van data.”

Voorkomen is beter dan genezen

Dit is een typisch geval waarbij geldt: “voorkomen is beter dan genezen”, data kwaliteit waarborgen is effectiever en uiteindelijk goedkoper naarmate het dichter bij de bron gebeurt. Data moet bij het importeren al direct worden gevalideerd, hiervoor is het belangrijk dat er binnen een organisatie een gestandaardiseerd datamodel leeft waarop men de validatie kan baseren. Met een standaard datamodel spreken de data als het ware overal dezelfde “taal”, dit faciliteert samenwerking en vergemakkelijkt het behouden van dataconsistentie en kwaliteit. Om dit model te vormen is het belangrijk met stakeholders rond de tafel te gaan zitten om zo iets neer te zetten waar iedereen achter staat, wat gepaard gaat met het mensen bewuster maken van het belang van data kwaliteit. Dit wordt bemoeilijkt doordat waarde die data genereert nog moeilijk te zien is op het punt waar het de organisatie binnenkomt, terwijl dit juist het punt is waar kwaliteitswaarborging de meeste zoden aan de dijk zet.

“Voorkomen is beter dan genezen.”

3. Aan de slag

Een praktische eerste stap naar het verbeteren van datakwaliteit is het vaststellen wat dit eigenlijk precies betekent in de context van jouw specifieke organisatie. Dit vereist het opstellen van duidelijke regels en def inities, die samen het datamodel vormen. Deze vormt vervolgens de basis voor het in kaart brengen van datakwaliteit binnen het proces, door middel van geautomatiseerde tests. Het resultaat is een duidelijk raamwerk waarbinnen data kwaliteit gemeten, bediscussieerd, en verbeterd kan worden.

Wat kunnen we in drie maanden bereiken?

Word een meer data-gestuurde gemeente in drie maanden. Haal bruikbare inzichten uit gegevens voor betere beslissingen.

MVP

Ontwikkel een MVP voor een use case die de organisatie helpt bij het nemen van een beslissing op basis van data.

Visiedocument

Maak een visiedocument, inclusief een stappenplan en concrete actiepunten voor de komende periode.